|

|

O Keynote de Andy Jassy, CEO da AWS, é um dos momentos mais esperados do re:Invent, a maior conferência de Computação em Nuvem do mundo. Isso porque é nesta palestra que os lançamentos mais importantes da AWS são anunciados.

O Keynote aconteceu hoje, 3 de dezembro, e levou ao público dezenas de novos serviços e features. Nós os dividimos em algumas áreas: Banco de Dados, Big Data, Machine Learning, Inteligência Artificial, Computação, Containers, Redes e Arquitetura de Nuvem Híbridas.

Você pode acompanhar todas as novidades abaixo:

Banco de Dados e Big Data

Amazon Managed Cassandra Service – MCS

É um banco de dados gerenciado, escalável e altamente disponível. O banco é compatível com Apache Cassandra, na versão 3.11 CQL API, sendo possível executar workloads com o mesmo código de aplicação e ferramentas usadas para Cassandra.

O serviço tem a velocidade de escrita e leitura na casa de unidades de milissegundos. O armazenamento de dados é completamente gerenciado e altamente disponível. Além disso, os dados são armazenados encriptados por padrão e replicados automaticamente em várias Zonas de Disponibilidade. O serviço tem integração com o Amazon Cloudwatch, Amazon VPC e AWS Key KMS.

Amazon S3 Access Points

O S3 foi o primeiro serviço lançado pela AWS, em 2006. Neste re:Invent, o lançamento de Access Points endereça a maneira como a utilização do serviço mudou com o tempo. Agora, é possível criar políticas de acesso diferenciadas, que definem como os dados podem ser acessados de acordo com cada aplicação, o que simplifica o gerenciamento do acesso aos dados.

Cada bucket do S3 pode ter diversos Access Points, sendo que cada um deles tem a sua própria política de acesso do IAM (AWS Identity and Access Management). Além disso, Access Points podem ser configurados para apenas permitir acessos dentro de uma Amazon Virtual Private Cloud.

Amazon Redshift RA3 Instances With Managed Storage

As novas instâncias usam o AWS Nitro System, usado também pelas instâncias EC2 anunciadas hoje. Essa novidade acompanha o novo modelo de armazenamento gerenciado do Redshift, que agora permite otimizar o poder computacional e o armazenamento das instâncias separadamente.

Com isso, o Redshift pode entregar 3x mais performance que qualquer outro data warehouse baseado na nuvem, segundo a AWS. Além disso, para os clientes que usam as instâncias Dense Storage (DS2), a performance e armazenamento pode aumentar em até 2x com o mesmo custo.

Redshift Federated Query

Essa atualização do Redshift permite a realização de consultas, a partir do serviço, em dados armazenados tanto no cluster quanto no S3, em bancos de dados no Amazon RDS para PostgreSQL e também Amazon Aurora para PostgreSQL. Assim, é possível romper as barreiras entre o seu data warehouse, data lake e banco de dados operacional.

Redshift Datalake Export

Essa feature permite exportar e salvar os dados transformados e enriquecidos no Redshift para um Data Lake no S3, em formato aberto. Os dados são exportados em formato Parquet, que é 2x mais rápido para transferir e consome 6x menos espaço que outros formatos de texto.

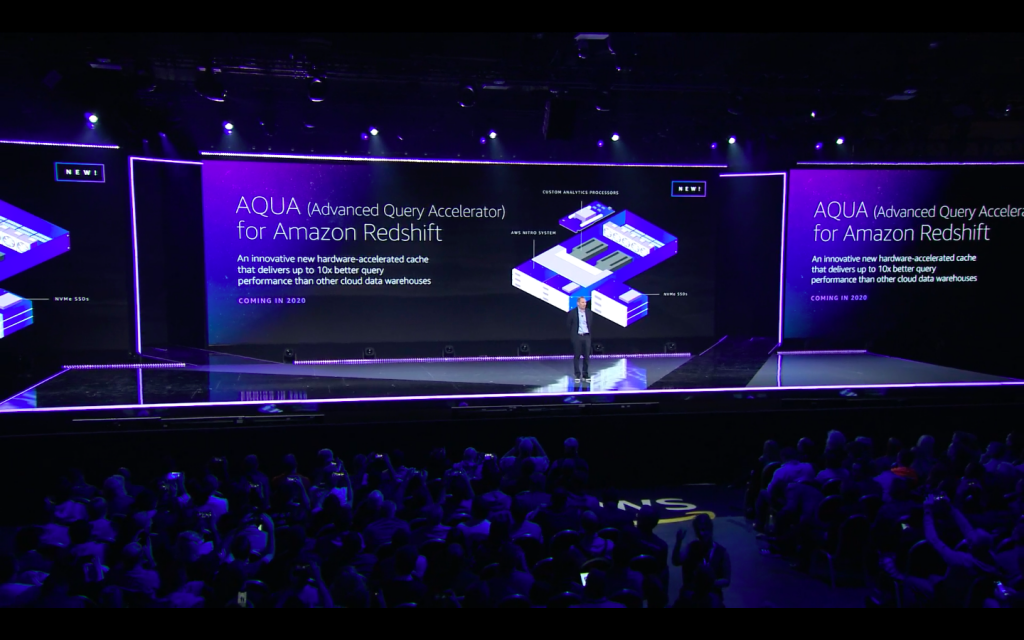

AQUA (Advanced Query Accelerator) for Amazon Redshift

Dados em Data warehouses com armazenamento centralizado precisam ser movidos para clusters, onde são processados. À medida que o Data warehouse cresce, esse trajeto pode prejudicar o seu desempenho.

Tendo isso em mente, o AQUA aproxima as camadas de computação e armazenamento ao fazer o processamento de boa parte dos dados no cache. Essa é, portanto, uma solução de cache distribuído, que pode processar uma grande quantidade de dados em paralelo em múltiplos nós e escalar automaticamente de acordo com a necessidade de aumento do espaço de armazenamento.

Isso faz com que o Redshift seja 10x mais veloz que qualquer outro data warehouse baseado na nuvem, segundo a AWS.

UltraWarm for Amazon Elasticsearch

UltraWarm é uma camada de armazenamento de dados quentes para o Elasticsearch. O serviço oferece até 900 TB de armazenamento e uma redução de custos de 90%, comparado a serviços similares. O UltraWarm permite realizar consultas e visualizar dados a partir da interface do Kibana. As consultas podem ser feitas usando as mesmas APIs usadas no Elasticsearch.

Machine Learning

Amazon Sagemaker Studio

É um ambiente de desenvolvimento para Machine Learning completamente integrado. O SageMaker Studio unifica todas as ferramentas necessárias para o desenvolvimento de algoritmos de Machine Learning. Com ele, os desenvolvedores podem escrever códigos, monitorar experimentos, visualizar dados e fazer debugging em um só ambiente. Além disso, como cada parte do workflow é integrada no ambiente, é possível navegar com facilidade entre cada etapa.

SageMaker Notebooks

Antes, uma das funcionalidades do SageMaker era a possibilidade de usar Jupyter Notebooks (personalizados pela AWS) para testar nossos códigos, já tendo toda a integração e permissionamento com a AWS via credenciais temporárias. Mas, para isso, era preciso selecionar um tipo de servidor EC2, que era então provisionado pela AWS. Agora, com os novos Notebooks SageMaker, é possível utilizar das mesmas facilidades de antes sem ter que levantar a EC2, pois a AWS gerencia toda a infraestrutura, dando flexibilidade para aumentar ou diminuir recursos sem interrupção do seu notebook e ainda automaticamente copiar e transferir notebooks para novas instâncias, tornando o serviço ainda mais “serverless”.

Sagemaker Experiments

É uma nova funcionalidade do Amazon SageMaker que permite organizar, monitorar, comparar e avaliar experimentos e versões de modelos de Machine Learning. Além disso, usando o SageMaker Studio, é possível comparar e visualizar os resultados dos experimentos.

Sagemaker Debugger

É uma nova funcionalidade do SageMaker. É possível usar o SageMaker Debugger SDK nos códigos de treinamento que usam as bibliotecas TensorFlow, Keras, Apache MXNet, PyTorch e XGBoost. O SDK salva o estado do modelo regularmente no S3.

Em resumo, o SDK pode ser usado para aplicar parâmetros definidos pelo desenvolvedor e por frameworks de Machine Learning ao modelo de treinamento. Isso ajuda a aumentar a precisão dos modelos de treinamento de algoritmos de Machine Learning.

SageMaker Model Monitor

Depois de desenvolver uma solução de Machine Learning (treinar o modelo, testar, validar se está tudo certo e colocar em produção), é preciso monitorar o modelo de produção para entender como ele está se comportando no mundo real. Essa tarefa é complexa, e requer bastante trabalho de escrever uma aplicação para interceptar os dados de entrada que estão chegando para o modelo em produção e entender se esses dados são parecidos com os dados com que nosso modelo foi treinado (o que é importantíssimo para garantir a qualidade do modelo em produção). A AWS lança hoje o SageMaker Model Monitor, que ajuda a interceptar os dados que chegam para o modelo, permitindo fazer análises quantitativas e de esquema, salvando diretamente no S3, de forma simples, o que aumenta a produtividade na hora de monitorar modelos em produção.

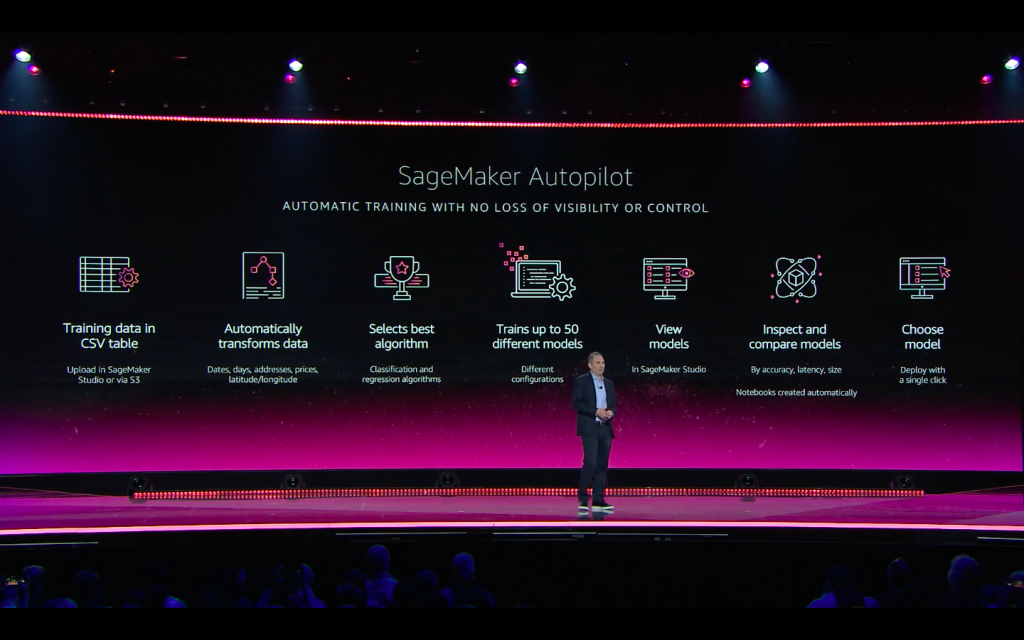

Amazon SageMaker Autopilot

Uma das tarefas de maior esforço na implementação Machine Learning é a escolha do algoritmo a ser utilizado, e depois, fazer o ajuste fino desse algoritmo configurando os hiperparâmetros. Esse processo é algo parecido com afinar um instrumento: se você for de menos, não tem som; se você for de mais, a corda arrebenta. O Samaker Autopilot auxilia o Cientista de Dados na escolha dos algoritmos para classificação e regressão.

O Sagemaker Autopilot primeiro inspeciona o seu dataset, executa algumas combinações para escolher a combinação ótima para o processo de transformação dos dados, o algoritmo e os hiperparâmetros a serem utilizados. Depois, ele usa essa combinação para treinar um inference pipeline (modelo composto por uma sequência linear de transformações), que você pode facilmente fazer o deploy do resultado em uma infraestrutura totalmente gerenciada pela AWS.

Por fim, o serviço também gera código em Python mostrando exatamente como os dados foram pré-processados, permitindo que possamos também usar o código feito pelo Autopilot para ajuste fino manual, ao invés de apenas entender o que foi feito.

Inteligência Artificial

Amazon Fraud Detector

Serviço completamente gerenciado que permite identificar potenciais atividade fraudulentas no ambiente online, como a criação de contas falsas ou fraudes de pagamentos. O serviço usa modelos de Machine Learning e a expertise em operações fraudulentas da Amazon.com e AWS para identificar tais atividades. É possível fazer a detecção em tempo real, assim como criar modelos a partir de dados de transações próprias.

Amazon CodeGuru

Nas ferramentas de apoio ao desenvolvimento, este serviço ajuda os desenvolvedores a produzirem código de melhor qualidade, utilizando o aprendizado nos milhões de deploys realizados pela Amazon.com para oferecer insights para desenvolvedores.

O Amazon CodeGuru analisa códigos buscando se boas práticas da AWS são seguidas, se há problemas de concorrência, validação input incorreta e muito mais. Além disso, consegue entender na aplicação onde estão os problemas de latência e CPU para entender quais as linhas de código são as mais custosas, de forma a ter uma visão mais clara de onde os desenvolvedores devem focar o esforço para executar melhorias.

Contact Lens for Amazon Connect

Esse serviço usa Machine Learning para identificar o sentimento, conteúdo e tendências de conversas com clientes em centros de atendimento. O Contact Lens transcreve e analisa as ligações de clientes automaticamente, assim como também transcreve ligações gravadas anteriormente. Além disso, é possível pesquisar as transcrições através de palavras-chave, frases e critérios de análise definidos. As transcrições podem ser revisadas quase em tempo real, à medida que as ligações estão acontecendo.

Amazon Kendra

É um serviço de Enterprise Search que usa Processamento de Linguagem Natural (PLN), campo de estudo que faz parte da área de Inteligência Artificial. Com esse serviço, é possível realizar pesquisas mais intuitivas, dentro das informações e canais disponíveis em uma organização. Kendra está disponível através do AWS Console e também como uma API, além de oferecer conexão com SharePoint Online, Amazon S3, e bancos de dados.

Computação

M6g R6g C6g instances for EC2

A nova geração de instâncias EC2 da AWS estará disponível no início de 2020. Essas instâncias são a evolução da A1, mas podem entregar até 7x mais desempenho que a geração A1. Elas são construídas usando o AWS Nitro System e usarão o novo processador ARM Graviton2.

Possuem diversos tamanhos, com ou sem armazenamento local, podendo chegar a 64 processadores virtuais de 512 GB de memória RAM. Essas instâncias possuem um desempenho significantemente maior que a 5ª geração (M5, C5, R5) de instâncias x86. chegando a 40% melhor relação preço/performance do que essas instâncias.

Existem planos da AWS de utilizar essas novas instâncias em serviços como o Elastic Load Balancer, Elastic Cache, Elastic Map Reduce (EMR), entre outros.

INF1 instances for ec2

Essas instâncias são voltadas para a redução de custos no processo de inferência, realizado por workloads de Machine Learning. As instâncias podem ser usadas em quatro tamanhos diferentes, usando os chips AWS Inferentia. Com elas, é possível fazer inferências rápidas e com baixa latência.

Containers

AWS Fargate for Amazon EKS

Agora é possível usar Amazon Elastic Kubernetes Service (EKS) para executar pods do Kubernetes no AWS Fargate. Isso significa que agora não é mais necessário provisionar e gerenciar infraestrutura para pods.

Redes

AWS Transit Gateway Multicast e inter-region peering

Esse serviço permite a conexão de milhares de AWS Virtual Private Clouds (VPCs) e redes on-premise através de um único gateway. Hoje, foram lançadas duas novas funcionalidades para AWS Transit Gateway Multicast: Inter-region peering, que permite criar redes globais privadas em múltiplas regiões da AWS; e Multicast, que permite aos usuários criarem aplicações multicast na nuvem e distribuir dados através de milhares de VPCs conectadas.

Arquitetura de Nuvem Híbridas

AWS Local Zones

Para atender clientes que necessitam de baixíssima latência e tempo de resposta para os clientes, a AWS lançou o Local Zones. Diferente das Availability Zones (AZs) que possuem alguns serviços na borda para DNS e caching, o Local Zones leva o processamento para mais próximo dos usuários. Assim, as empresas conseguem ter servidores, balanceadores de carga, bancos de dados e muito mais, perto do usuário, com uma latência de um dígito de milissegundo.

A primeira Local Zone lançada é a de Los Angeles e, em breve, espera-se outras ao redor do mundo, próximas a grandes cidades.

AWS Wavelenght

Wavelenght é um novo serviço da AWS, entregue em parceria com Verizon, empresa global de comunicações e tecnologia. O serviço permite o desenvolvimento de aplicações para mobile, com latência na casa das unidades de milissegundos na rede 5G da operadora. Para isso, usa-se as mesmas APIs e ferramentas comuns à AWS.

Mais lançamentos

Além desses lançamentos, na próxima quinta acontece o keynote do Werner Vogels, vice-presidente e CTO da Amazon. Nele, esperamos diversas novidades principalmente voltadas para desenvolvedores e gerentes dos ambientes.

Entre em Contato

Tem interesse em saber mais sobre os lançamentos e como implementá-los? Entre em contato conosco e converse com os nossos especialistas.